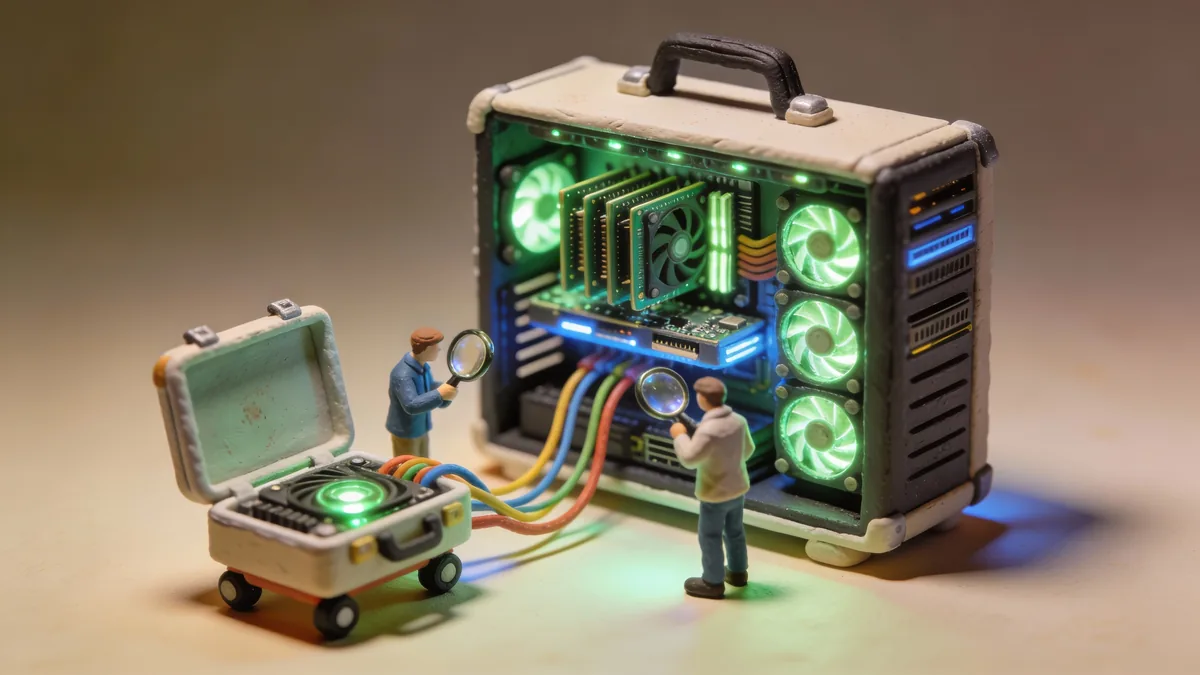

768 ГБ видеопамяти в чемодане: как энтузиаст собрал мобильный AI-сервер

Сборка с 10 GPU и 768 ГБ VRAM за $10,000 в корпусе Thermaltake. Запускает DeepSeek и другие MoE-модели локально.

Пока корпорации строят гигаваттные дата-центры, энтузиаст из сообщества LocalLLaMA собрал портативную систему с 768 ГБ видеопамяти. Десять GPU в закрытом корпусе, две серверные блоки питания, и всё это помещается в формат, который можно перевозить. Стоимость проекта — меньше $10,000.

Идея и реализация

Автор сборки искал способ запускать большие MoE-модели вроде DeepSeek и Kimi K2 локально. Эти модели требуют сотни гигабайт памяти для полного инференса без квантования. Обычные решения — либо несколько отдельных машин с NVLink, либо открытые майнинг-фреймы с россыпью видеокарт.

Оба варианта его не устроили. Связка машин дорогая и сложная в настройке. Майнинг-фреймы выглядят как серверная стойка в гараже — пыль, шум, провода наружу. Хотелось что-то закрытое, что можно при необходимости погрузить в машину.

Решением стал корпус Thermaltake Core W200. Это двухсистемный корпус, изначально рассчитанный на две независимые сборки. Но если установить материнскую плату вверх ногами во второй отсек, освобождается пространство для десяти видеокарт с соответствующим охлаждением.

Характеристики сборки

Десять GPU суммарно дают 768 ГБ видеопамяти. Это не RTX 4090 — скорее всего, использованы карты с большим объёмом VRAM вроде профессиональных решений или серверных ускорителей. Точная конфигурация в оригинальном посте не раскрыта, но математика сходится на картах по 48-96 ГБ каждая.

Питание обеспечивают два блока: EVGA 1600W и Asrock 1300W. Почти три киловатта на входе — серьёзная нагрузка, но для десяти GPU под нагрузкой это разумный запас.

Компоненты:

- Корпус: Thermaltake Core W200

- GPU: 10 штук, суммарно 768 ГБ VRAM

- БП: EVGA 1600W + Asrock 1300W

- Охлаждение: воздушное, встроенные вентиляторы корпуса

- Итоговая стоимость: ~$10,000

Зачем столько памяти

Современные MoE-модели масштабируются иначе, чем dense-модели. DeepSeek V3 имеет 671 миллиард параметров, но активирует только часть из них на каждом токене. Чтобы хранить все веса в памяти без офлоада на SSD, нужно несколько сотен гигабайт.

Квантование помогает, но ценой качества. INT4 или GGUF сжимают модель в разы, однако теряют нюансы. Для экспериментов с полной точностью или fine-tuning нужен весь объём.

С 768 ГБ можно загрузить DeepSeek V3 в FP16 целиком и получать ответы без подгрузки частей модели с диска. Это кратно ускоряет генерацию — SSD-офлоад даёт единицы токенов в секунду, а всё в VRAM — десятки или сотни.

Сравнение с альтернативами

Облачные GPU с таким объёмом памяти стоят сотни долларов в час. Восемь A100 на 80 ГБ (640 ГБ суммарно) у крупных провайдеров обойдутся в $20-30/час. За пару сотен часов инференса набегает стоимость этой сборки.

Готовые решения вроде Lambda Labs Hyperplane или NVIDIA DGX начинаются от $50,000 и требуют серьёзной инфраструктуры. Самосборная система за $10,000 не даёт такой же производительности на ватт, но решает конкретную задачу — много памяти за разумные деньги.

| Вариант | VRAM | Стоимость | Мобильность |

|---|---|---|---|

| Эта сборка | 768 ГБ | ~$10,000 | Да |

| 8x A100 (облако) | 640 ГБ | $25/час | Нет |

| NVIDIA DGX A100 | 640 ГБ | $199,000 | Нет |

| Mac Studio M2 Ultra | 192 ГБ | $8,000 | Да |

Практические вопросы

Автор отмечает, что система работает, но не без нюансов. Шум под нагрузкой значительный — это десять видеокарт с активным охлаждением в закрытом корпусе. Потребление под три киловатта требует соответствующей проводки.

Транспортировка возможна, но корпус весит как небольшой холодильник. «Мобильный» здесь означает «можно перевезти», а не «можно носить в рюкзаке».

Софтверная часть тоже требует внимания. Десять GPU нужно объединить для инференса — не все фреймворки делают это автоматически. vLLM, TGI и подобные инструменты справляются, но настройка занимает время.

Что это значит

Сборка показывает, куда движется локальный AI. Год назад 768 ГБ VRAM казались избыточными — модели помещались в 48-96 ГБ с квантованием. Сегодня MoE-архитектуры требуют сотен гигабайт для полного раскрытия потенциала.

Для исследователей и энтузиастов это способ экспериментировать с передовыми моделями без облачных счетов. Для индустрии — сигнал, что спрос на высокопамятные решения растёт быстрее, чем предложение.

Если тренд продолжится, через год мы увидим сборки на терабайт и больше. Вопрос только в том, кто первым сделает это в форм-факторе меньше шкафа.