Orchestrator-8B: как маленькая модель NVIDIA обыгрывает GPT-5

NVIDIA выпустила Orchestrator-8B — модель-дирижёр, которая координирует другие LLM и инструменты. На сложных задачах она превосходит GPT-5 при 30% стоимости.

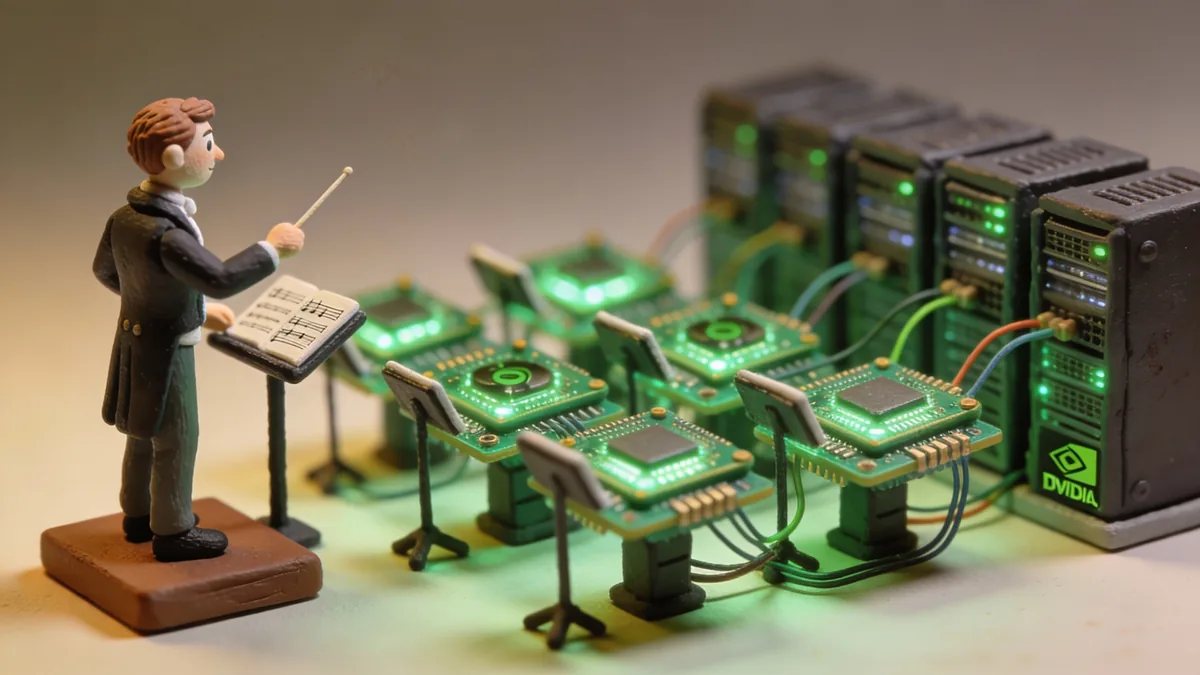

Что, если вместо одной огромной модели, которая пытается всё делать сама, использовать маленькую модель-дирижёра? Она сама решает, когда ответить напрямую, а когда передать задачу специализированному инструменту или более мощной LLM. Именно такой подход реализовала NVIDIA в своей новой модели Orchestrator-8B.

Принципиально новый подход

Orchestrator-8B — это не очередная языковая модель для чат-ботов. Это специализированный контроллер, обученный управлять набором инструментов и моделей для решения сложных задач. Вместо того чтобы самой генерировать ответы, она выбирает оптимальный путь: вызвать веб-поиск, запустить код в песочнице, обратиться к математической модели Qwen2.5-Math-72B или делегировать задачу GPT-5.

Модель построена на базе Qwen3-8B и обучена методом reinforcement learning с тремя целями одновременно: максимизировать точность, минимизировать стоимость и снизить задержку. Такой подход исследователи из NVIDIA Research назвали ToolOrchestra.

Результаты на бенчмарках

На сложных агентных бенчмарках Orchestrator-8B показывает результаты лучше, чем GPT-5 с доступом к тем же инструментам:

| Бенчмарк | Orchestrator-8B | GPT-5 |

|---|---|---|

| Humanity's Last Exam | 37.1% | 35.1% |

| FRAMES | 76.3% | 74.0% |

| τ²-Bench | 80.2% | 77.7% |

При этом средняя стоимость запроса составляет 9.2 цента против 30.2 центов у GPT-5, а время выполнения — 8.2 минуты против 19.8. То есть маленькая модель не просто не уступает гиганту, но работает в 2.5 раза быстрее при трети стоимости.

Технические характеристики

- Параметры: 8 миллиардов

- Архитектура: decoder-only Transformer

- Базовая модель: Qwen3-8B

- Лицензия: NVIDIA Open Model License

- Доступность: Hugging Face

Модель поддерживает до 50 шагов в одной сессии и работает с тремя категориями инструментов: базовые (веб-поиск, Python-песочница), специализированные LLM (для математики и кода) и универсальные LLM (GPT-5, Llama-3.3-70B).

Почему маленькая модель справляется лучше

Исследователи обнаружили интересный феномен: когда GPT-5 используется как оркестратор, она в 98% случаев направляет запросы к себе или своей мини-версии. Это «предвзятость к самоулучшению» — модель переоценивает собственные возможности. Orchestrator-8B, обученная с нуля именно на задачу координации, распределяет вызовы более равномерно.

Как объясняют в NVIDIA: «Маленькие модели не обременены избыточными знаниями и обучены схватывать суть решения задач благодаря своему ограниченному размеру».

Что это значит для разработчиков

Архитектура с отдельным оркестратором открывает несколько возможностей. Для локального развёртывания — запустить Orchestrator-8B можно на одной видеокарте, а тяжёлые вычисления делегировать облачным API. Для оптимизации затрат — модель сама выбирает, когда достаточно простого инструмента, а когда нужна frontier-модель. Для масштабирования — добавление новых инструментов не требует переобучения самого оркестратора.

Код и датасет ToolScale опубликованы на GitHub. NVIDIA позиционирует этот релиз как «первый шаг к фундаментально интеллектуальным составным AI-системам», которые придут на смену монолитным моделям.